近日,北京理工大学机械与车辆学院、智能无人系统技术国家级重点实验室徐彬、王伟达、王力老师团队联合清华大学、新加坡国立大学等单位,在Nature子刊发布了国际首个复杂环境自动驾驶双4D成像毫米波数据集Dual Radar,采集非理想工况感知数据总里程超过400公里,标注三维目标检测和跟踪的数据超过10000帧同步帧,用于评测现有感知算法在真实非理想工况数据上的性能表现。相关研究成果以“Dual Radar: a Multi-modal Dataset with Dual 4D Radar for Autononous Driving”为题发表在Scientific Data上,该期刊专注于发表具有科学价值的数据集。北京理工大学助理教授王力为本文通信作者。

自动驾驶系统的环境感知是确保安全性和可靠性的核心,但现有的传感器技术在复杂多变的驾驶环境中仍面临许多挑战。4D毫米波雷达具有比传统3D雷达更高的点云密度和精确的垂直分辨率,使其在自动驾驶环境感知中的不利情况下具有前景。目前,自动驾驶领域还缺乏对4D毫米波雷达不同点云密度和噪声水平的比较分析,现有数据集基于单一类型的4D毫米波雷达,在同一场景中难以兼顾长距离点云数据和广视野点云数据,无法进行点云密度和噪声水平的直接对比。为了应对这一问题,研究团队提出了一个新的数据集Dual Radar,通过引入两种特性不同的4D雷达,来实现对长距离和广视野性能迥异的雷达数据综合分析,推动自动驾驶在恶劣天气、复杂光照等环境感知技术的发展。

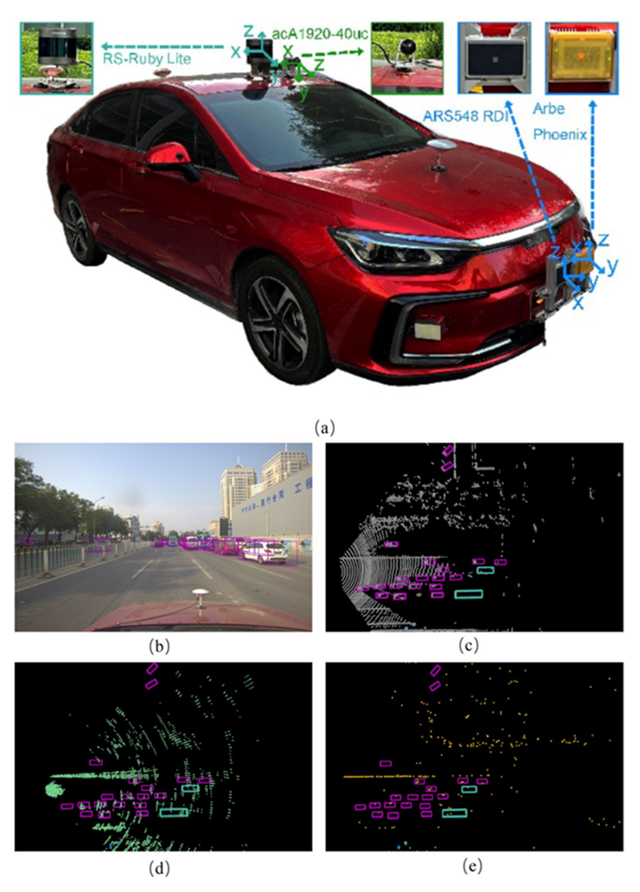

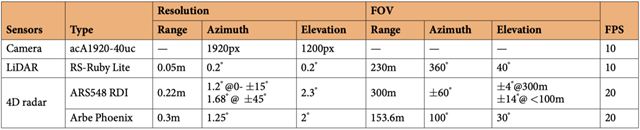

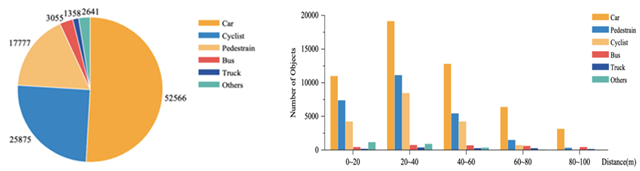

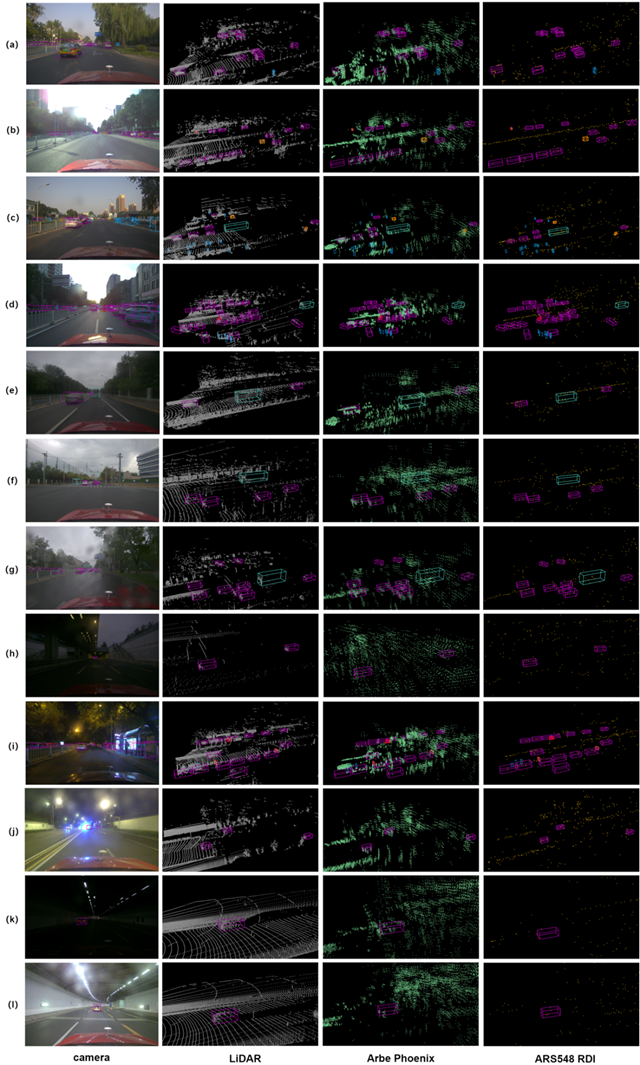

Dual Radar数据集的采集车辆如图1所示,包含了四种传感器,分别为高分辨率相机、激光雷达和两种不同类型的4D雷达:Arbe Phoenix和ARS548 RDI,具体参数配置如表1所示。该数据集共包含151个连续时间序列,涵盖了10007个同步标注帧,数据集的类别包括汽车、行人、骑行者,公交车、卡车和其他物体,类别数量和距离分布如图2所示。该数据集涵盖了多个具有挑战性的场景,包括:不同的道路条件(城市道路和隧道);不同的天气条件:晴天、阴天和恶劣天气(雨天等);不同的光照强度:正常光照和逆光;不同的时间段:白天、黄昏和夜间,三维目标检测标注情况如图3所示。这些场景的多样性能够帮助研究人员验证不同传感器在各种环境下的表现,并为自动驾驶系统提供更全面的测试数据。

图1 Dual Radar数据采集车及各数据目标检测标注情况(分别为图像、激光雷达点云、Arbe Phoenix点云和ARS548 RDI点云)

表1 车载传感器参数配置

图2 多类别目标数量统计和目标距离分布统计

图3 Dual Radar数据集三维目标检测标注可视化

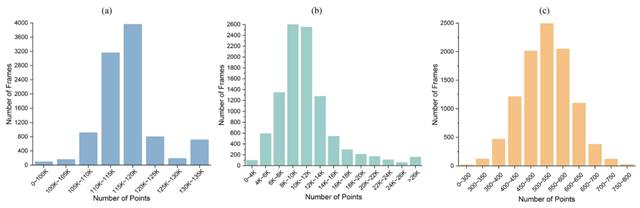

该数据集的两个不同类型的雷达传感器:Arbe Phoenix雷达和ARS548 RDI雷达,能够收集不同类型的点云数据。其中,ArbePhoenix雷达具有较高的点云密度,能够提供更广的视野覆盖,尽管存在较多噪声,但它能够捕捉到更多的物体信息,尤其在检测大型物体(如汽车)时表现突出。与Arbe Phoenix相比,ARS548 RDI雷达产生的噪声较少,点云密度较低,但它在长距离探测中表现更为精准,特别适合检测远距离或较小物体(如行人和自行车)。数据帧的点云数量统计结果如图4所示。通过对比这两种雷达点云的密度与噪声水平,研究团队验证了双4D雷达在多种驾驶场景下的优异表现,特别是在复杂环境中,双雷达融合显著提高了物体检测与跟踪的准确性。该数据集不仅解决了传统技术中的点云稀疏和噪声问题,还为自动驾驶感知算法提供了宝贵的测试数据,特别是在多模态传感器数据融合任务中的应用。

图4 数据帧的点云数量统计。(a)显示大多数激光雷达点云数量在110K 和120K 之间。(b)显示Arbe Phoenix 点云数量在6K 和14K 之间。(c) 显示ARS548 RDI 点云数量在400 和650 之间。

研究团队的这项工作中数据涵盖恶劣天气(雨雾)、弱光昼夜、背光逆光等传统数据集未充分覆盖的挑战性环境,填补了现有数据集在极端条件下的空白,可为自动驾驶领域的感知技术发展提供了新的数据支持,尤其是在提升自动驾驶车辆在复杂环境中全天候可靠性和安全性方面,具有较好的应用潜力,有望推动自动驾驶感知系统向低成本、高鲁棒、全场景方向跨越式发展。

评论

文明上网理性发言,请遵守新闻评论服务协议

登录参与评论

0/1000